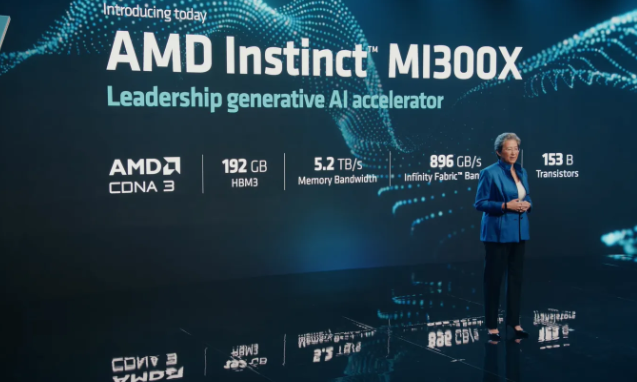

AMD公司发布了新的MI300X人工智能加速器芯片,直接挑战英伟达H100的统治地位,此举是为了搭上人工智能热潮。这家科技巨头的人工智能芯片库的最新成员,旨在颠覆英伟达在人工智能加速器市场的主导地位。

MI300X是为人工智能任务明确定制的,它配备了高达192GB的内存,使其成为执行大型模型如LLM的理想选择。AMD选择高内存配置是一个战略性的选择,能够轻松部署庞大的模型。人工智能训练需要大量的计算能力,但总的来说,它需要大量的vRAM来存储训练过程中的信息--这就是为什么一些游戏GPU可能适合挖掘加密货币,但对于人工智能任务来说并不是真的很好。

此外,该芯片的底层架构已经被设计成能够顺利支持生成性人工智能工作负载。AMD首席执行官Lisa Su指出,最新一代的前沿模型可以很容易地在MI300X的192GB HBM3(高带宽内存)中找到家。

"有了所有这些额外的内存容量,我们实际上对大型语言模型有一个优势,因为我们可以直接在内存中运行更大的模型"。Lisa Su详细解释说,用户将需要更少的GPU来在更短的时间内完成同样的任务。

这款产品的推出正值英伟达的市值达到1万亿美元大关之时。虽然AMD的市值还不能与之相比--它刚刚超过2070亿美元--但MI300X的发布凸显了AMD在不断扩大的人工智能领域做出成绩的决心。

为了进一步证明其承诺,AMD在MI300X上成功运行了Falcon 40B LLM。按照Lisa Su的说法,这一成就标志着 "第一次可以完全在内存中运行这种规模的LLM"。

更多财经请关注 WX: Chaocaijing123456

币海财经: 全球财讯门儿清 https://www.bihai123.com/

声明: 本文由入驻币海编者上传,观点仅代表编者本人,不代表币海财经赞同其观点或证实其描述,请自行判断。

延伸阅读